Publicidade

As fortes vendas dos chips da Nvidia (NVDC34), que alimentam modelos de IA como o GPT-4, da OpenAI, estão entre as maiores histórias de tecnologia em 2024. O rápido crescimento da empresa resultou em um aumento de 200% no valor de suas ações nos últimos 12 meses, elevando a Nvidia ao seleto grupo de empresas com valores de mercado superiores a US$ 2 trilhões (por um breve período, o valor chegou a ultrapassar os US$ 3 trilhões).

A pergunta que muitas pessoas fazem é quem conseguiria vencer a Nvidia, que hoje controla 80% do mercado de chips de IA? No entanto, vários analistas disseram recentemente à Fortune que essa pergunta está equivocada. Como afirmou Daniel Newman, CEO do Grupo Futurum, atualmente não há “nenhum concorrente natural para a Nvidia no mercado”.

Baixe uma lista de 10 ações de Small Caps que, na opinião dos especialistas, possuem potencial de crescimento para os próximos meses e anos

Eis o porquê: as unidades de processamento gráfico (GPUs) da Nvidia, originalmente desenvolvidas em 1999 para rodar gráficos 3D ultrarrápidos em videogames para PC, mostraram-se ideais para treinar modelos massivos de IA generativa. Esses modelos, que estão em constante crescimento, são utilizados por empresas como a OpenAI, Google, Meta, Anthropic e a Coheré. Hoje, esse treinamento requer acesso a um grande número de chips de IA. As GPUs da Nvidia são consideradas as mais poderosas e são as mais procuradas há anos.

Elas certamente não são baratas: o treinamento dos principais modelos de IA generativa requer a utilização de dezenas de milhares de GPUs de última geração, cada qual custando entre US$ 30 mil e US$ 40 mil. Elon Musk, por exemplo, afirmou recentemente que o modelo Grok 3 de sua empresa X.ai precisará ser treinado utilizando 100 mil das melhores GPUs da Nvidia para se tornar “algo especial”. Isso representaria mais de US$ 3 bilhões em receita com chips para a Nvidia.

Continua depois da publicidade

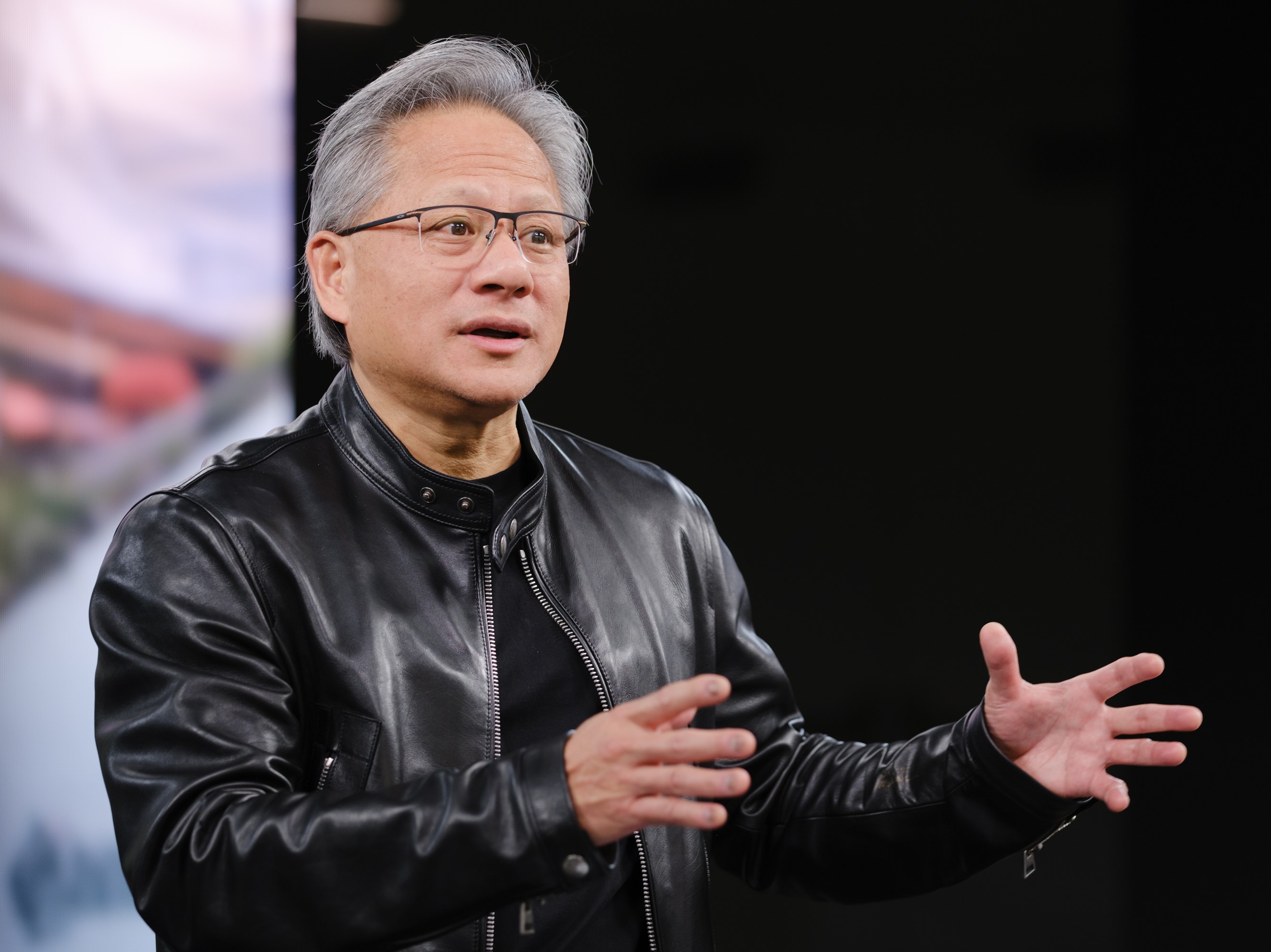

O sucesso da Nvidia não é produto apenas dos chips, mas também do software que os torna acessíveis e utilizáveis. O ecossistema de software da Nvidia se tornou o padrão para um grande número de desenvolvedores focados em IA, que têm pouco incentivo para mudar. Na reunião anual de acionistas realizado na semana passada, Jensen Huang, CEO da Nvidia, chamou a plataforma de software da empresa, a CUDA (Compute Unified Device Infrastructure), de um “círculo virtuoso”. Com mais usuários, a Nvidia pode investir mais nas atualizações desse ecossistema, dessa forma atraindo ainda mais usuários.

Por outro lado, a AMD, concorrente da Nvidia no setor de semicondutores e que controla cerca de 12% do mercado global de GPUs, possui produtos competitivos e está aprimorando seu software, de acordo com Newman. Mas embora possa fornecer uma alternativa para empresas que não querem ficar presas à Nvidia, ele não possui a base de usuários existente de desenvolvedores que consideram o CUDA fácil de usar.

Além disso, embora cada um dos grandes provedores de serviços em nuvem, como o AWS, da Amazon, o Microsoft Azure e o Google Cloud desenvolvam seus próprios chips proprietários, eles não pretendem substituir a Nvidia. Em vez disso, eles desejam ter uma variedade de chips de IA à disposição para otimizar sua própria infraestrutura de data center, manter os preços baixos e vender seus serviços em nuvem para o maior número possível de clientes.

“A Nvidia tem a vantagem inicial, e quando você estabelece um mercado que está crescendo rapidamente, é difícil para os outros alcançarem”, explicou o analista Jack Gold, da J. Gold Associates, que destacou que a Nvidia fez um excelente trabalho ao criar um ecossistema único que os concorrentes não possuem.

Matt Bryson, vice-presidente sênior de pesquisa de ações da Wedbush, também observou que substituir os chips da Nvidia para o treinamento de modelos de IA em larga escala seria particularmente desafiador. Ele explicou que a maior parte dos gastos atuais em poder de computação está direcionada para essa área. “Não acredito que essa dinâmica mude por algum tempo”, disse.

No entanto, um número cada vez maior de startups de chips de IA, como a Cerebras, a SambaNova, a Groq e a mais recente, a Etched, enxergam uma oportunidade para capturar pequenas fatias do mercado de chips de IA da Nvidia. Elas estão focando nas necessidades especializadas das empresas de IA, especialmente naquilo que é conhecido como “inferência”, ou seja, na execução de dados por meio de modelos de IA já treinados para gerar informações (como cada resposta do ChatGPT, por exemplo, que requer inferência).

Na semana passada, por exemplo, a Etched arrecadou US$ 120 milhões para desenvolver um chip especializado projetado especificamente para executar modelos Transformer, um tipo de arquitetura de modelo de IA utilizado pelo ChatGPT, da OpenAI, pelo Gemini, do Google, e pelo Claude, da Anthropic.

Leia mais: Jensen Huang: quem é o líder da Nvidia, mais nova estrela da IA

Continua depois da publicidade

Enquanto isso, a Groq, que se especializa na execução extremamente rápida de modelos, está supostamente levantando novos fundos com uma valoração de US$ 2,5 bilhões. Ao mesmo tempo, a Cerebras teria entrado com um pedido confidencial para uma oferta pública inicial apenas alguns meses após lançar seu mais recente chip, que a empresa alega ser capaz de treinar um modelo de IA 10 vezes maior que o GPT-4 ou Gemini.

Todas essas startups provavelmente se concentrarão inicialmente em um mercado pequeno, como o fornecimento de chips mais eficientes, mais rápidos ou mais baratos para determinadas tarefas. Eles também podem focar mais em chips especializados para indústrias específicas ou em dispositivos alimentados por IA, como PCs e smartphones. “A melhor estratégia é criar um nicho e não tentar conquistar o mundo, que é o que a maioria deles está tentando fazer”, afirmou Jim McGregor, analista principal da Tiias Research.

Então, talvez uma pergunta mais pertinente seja: quanta participação de mercado essas startups, juntamente com provedores de nuvem e gigantes de semicondutores como AMD e Intel, conseguiriam conquistar?

Isso ainda está por ser visto, especialmente porque o mercado de chips para execução de modelos de IA, ou inferência, ainda é muito novo. Mas, na semana passada, durante a reunião anual de acionistas da Nvidia, Huang deixou claro aos investidores que à medida que os rivais pressionam para reduzir a fatia de mercado da Nvidia, a Nvidia planeja inovar e continuar a ser o padrão ouro em chips de treinamento de IA.

Quando a Nvidia lançar seu sistema Blackwell ainda este ano, que ultrapassará a potência de seus atuais chips H100, ela apenas consolidará sua liderança, afirmou. “A plataforma de arquitetura Blackwell provavelmente será o produto de maior sucesso em nossa história”, disse Huang.

Entretanto, em longo prazo, os analistas identificam várias áreas onde os concorrentes podem prosperar, especialmente no que diz respeito ao uso de eletricidade, um custo significativo para empresas que treinam e operam modelos de IA. “Acho que a questão de energia pode criar espaço para alternativas competitivas”, disse Bryson. “Os data centers de GPU estão demandando cada vez mais energia à medida que os modelos crescem em tamanho, e uma solução que reduza significativamente os requisitos de energia pode ganhar uma tração substancial.”

A Nvidia também deve estar atenta a problemas antitruste. A Reuters informou na segunda-feira que a Nvidia será acusada pelo regulador antitruste francês por “práticas supostamente anticompetitivas”, o que a tornaria a primeira agência reguladora a fazer isso. Nos EUA, o Departamento de Justiça está investigando a Nvidia. Quaisquer casos antitruste podem potencialmente desacelerar a Nvidia, ao mesmo tempo que deixam espaço para rivais menores preencherem a lacuna.

Os concorrentes da Nvidia certamente poderiam aproveitar qualquer vantagem que pudessem obter, já que, pelo menos por enquanto, a Nvidia parece estar tranquila na liderança.

“Certamente se poderia argumentar que a Nvidia está se posicionando para ser praticamente insubstituível, a menos que algo realmente impactante ocorra para mudar esse mercado”, disse Newman. Mas ele argumentou que o “enorme” mercado de chips especiais deve abrir espaço para muitos outros players.

“Se a IA for uma tendência tão grande como todos acreditamos que seja, haverá esse ecossistema realmente saudável de fabricantes de chips e desenvolvedores de software que surgem para resolver problemas específicos de aplicativos”, disse.

Continua depois da publicidade

Fortune: ©.2024 Fortune Media IP Limited/Distribuído por The New York Times Licensing Group